Reasoning AI: Die Illusion des Denkens - Vollständige Analyse zwischen Hype und Realität 2025

OpenAI o3 erreicht 88% bei ARC-AGI, aber Apple enthüllt, dass Reasoning AI eine Illusion ist. Tiefgreifende Analyse von Reasoning-Modellen: echte Durchbrüche oder sophistiziertes Pattern Matching? Alle Daten, Kosten und Limitationen.

Table of Contents

2025 erlebte das größte Paradox der künstlichen Intelligenz: Während OpenAI o3 Rekordergebnisse erzielte (88% bei ARC-AGI), veröffentlichte Apple eine vernichtende Studie, die Reasoning-Modelle als “eine Illusion des Denkens” definierte. Dieser Widerspruch offenbart eine unbequeme Wahrheit über die Zukunft der KI.

Der Große Widerspruch der Reasoning AI

Stellen Sie sich vor, am selben Tag zwei Schlagzeilen zu lesen: “OpenAI o3 revolutioniert KI mit übermenschlichem Reasoning” und “Apple beweist, dass Reasoning AI eine komplette Illusion ist”. Willkommen im Paradox von 2025.

Auf der einen Seite haben wir beispiellose technologische Durchbrüche. Auf der anderen strengen wissenschaftlichen Studien, die die theoretischen Grundlagen dieser Fortschritte demontieren. Die Realität, wie so oft in der Technologie, ist komplexer als sensationelle Schlagzeilen suggerieren.

Die Explosion des Test-Time Compute Scaling

OpenAI o3: Die 10.000$ pro Aufgabe Revolution

Test-time compute scaling hat 2025 die KI-Spielregeln komplett verändert. OpenAI o3 nutzt 170-mal mehr Rechenleistung während der Inferenz verglichen mit der effizienten Version und erreicht 88% bei ARC-AGI gegenüber 76% der Standardversion.

Die Kosten? Über 10.000$ pro komplexer Aufgabe. Um das in Perspektive zu setzen: François Chollet (Schöpfer von ARC-AGI) berechnete, dass man einen Menschen für etwa 5$ für dieselbe Aufgabe bezahlen könnte. Aber die Ergebnisse sind unbestreitbar: o3 erreichte 69,1% Genauigkeit bei SWE-Bench Verified, eine erhebliche Verbesserung gegenüber o1s 48,9%.

DeepSeek Demokratisierung: Gleiche Ergebnisse, Reduzierte Kosten

DeepSeek-R1 löste Panik an den Finanzmärkten aus, als es demonstrierte, dass ähnliche Performance wie OpenAI o1 mit nur 6 Millionen Dollar Entwicklungskosten erreicht werden konnte. Das Ergebnis? Ein 17%iger Crash der Nvidia-Aktien in einer einzigen Sitzung.

Dieses Open-Source-Modell machte deutlich, dass Innovation in Reasoning AI nicht notwendigerweise milliardenschwere Investitionen erfordert. DeepSeek-R1-Zero entwickelte natürlich fortgeschrittene Reasoning-Verhaltensweisen durch pures Reinforcement Learning, ohne anfängliches supervised Fine-tuning.

Apple Zerstört den Mythos: “Die Illusion des Denkens”

Die Revolutionäre Studie vom 7. Juni 2025

Das Apple-Team unter der Leitung von Parshin Shojaee und Samy Bengio veröffentlichte “The Illusion of Thinking” mit einer völlig neuen Methodologie. Anstatt sich auf traditionelle Benchmarks zu verlassen (anfällig für Datenkontamination), erstellten sie kontrollierbare logische Rätsel, die pures Reasoning erfordern.

Die Ergebnisse waren verheerend für die Reasoning AI-Industrie.

Systematische Ausfälle von Apple Entdeckt

Zusammenbruch jenseits der Komplexitätsschwellen: Modelle zeigen einen “kompletten Genauigkeitseinbruch”, wenn Probleme bestimmte Schwierigkeitsschwellen überschreiten. Paradoxerweise reduzieren Modelle, anstatt die Anstrengung zu intensivieren, die Anzahl der verwendeten Tokens und geben kürzere Antworten.

Versagen bei der Nutzung expliziter Algorithmen: Selbst wenn der Lösungsalgorithmus für den Turm von Hanoi bereitgestellt wurde, verbesserte sich die Performance nicht. Dies deutet auf grundlegende Limitationen beim Aufrechterhalten kohärenter Reasoning-Ketten hin.

Das Overthinking-Phänomen: Bei einfachen Problemen übertrafen Non-Reasoning-Modelle oft die fortgeschrittenen, die dazu neigten zu “überdenken” und die richtige Antwort zu verlieren.

Die Gegenoffensive: “Die Illusion der Illusion”

Die Antwort der Wissenschaftsgemeinschaft

Alex Lawsen von Open Philanthropy veröffentlichte eine detaillierte Widerlegung mit dem Titel “The Illusion of the Illusion of Thinking” und argumentierte, dass viele von Apples auffälligen Ergebnissen aus experimentellen Fehlern stammen.

Die Hauptkritik? Token-Budget-Limits, die Apple angeblich bei der Ergebnisinterpretation ignoriert hätte. Als Apple behauptete, dass Modelle bei Rätseln mit 8+ Türmen von Hanoi-Scheiben “zusammenbrachen”, erreichten Modelle wie Claude bereits ihre rechnerischen Grenzen.

Stanfords Widersprüchliche Beweise

Der Stanford AI Index 2025 präsentiert eine komplexe Realität: Während sich Reasoning-Modelle dramatisch verbessert haben (o1 erreichte 74,4% bei einer Internationalen Mathematik-Olympiade-Prüfung, verglichen mit GPT-4os 9,3%), kosten sie fast 6-mal mehr und sind 30-mal langsamer.

Ein entstehender Trend zeigt jedoch Performance-Konvergenz: Der Abstand zwischen dem ersten und zehnten platzierten Modell fiel von 11,9% auf 5,4% in einem Jahr, was darauf hindeutet, dass wir ein Plateau in grundlegenden Fähigkeiten erreichen.

Meta-Analyse: Was Wirklich Funktioniert

Metas Kontraintuitive Studie

Meta-Forschung enthüllte, dass KI-Modelle 34,5% bessere Genauigkeit mit kürzeren Reasoning-Ketten erreichen, was Industrieannahmen herausfordert und potenziell Rechenkosten um 40% reduziert.

Dieses kontraintuitive Ergebnis legt nahe, dass “mehr Reasoning” nicht immer “besseres Reasoning” bedeutet - eine Entdeckung, die den Ansatz zur Reasoning AI revolutionieren könnte.

Stanfords Meta-CoT: Die Zukunft des Reasoning

Forscher von SynthLabs und Stanford schlugen Meta Chain-of-Thought (Meta-CoT) vor, ein Framework, das latente Reasoning-Prozesse modelliert, die zur Lösung komplexer Probleme notwendig sind. Im Gegensatz zu traditionellem CoT integriert Meta-CoT einen strukturierten Ansatz, inspiriert von der Dual-Prozess-Theorie der Kognitionswissenschaften.

Unprogrammierte Emergente Verhaltensweisen

DeepSeeks Autonomes Lernen

DeepSeek-R1-Zero stellt eine faszinierende Fallstudie dar: Es entwickelte mächtige Reasoning-Verhaltensweisen durch pures Reinforcement Learning, ohne anfängliches supervised Fine-tuning. Es zeigte jedoch auch Herausforderungen wie schlechte Lesbarkeit und Sprachmischung.

DeepSeeks Hypothese ist gewagt: “Können wir das Modell einfach für Korrektheit belohnen und es autonom den besten Denkweg entdecken lassen?”

Emergente Fähigkeiten in Wissenschaftlichen Domänen

Ein Vergleich bei wissenschaftlichen Computing-Aufgaben offenbarte, dass alle drei Reasoning-Modelle (DeepSeek R1, ChatGPT o3-mini-high und Claude 3.7 Sonnet) die Steifheit des ODE-Systems erkannten und eine implizite Methode wählten, während alle Non-Reasoning-Modelle versagten.

Dies deutet auf echte emergente Fähigkeiten in spezifischen Domänen hin, auch wenn allgemeine Limitationen bestehen bleiben.

Die Kosten der Komplexität und Skalierbarkeit

Unhaltbare Ökonomische Trade-offs

Das Test-time Compute Scaling-Paradigma präsentiert drastische Trade-offs. Mit o3, das 17-20$ pro Aufgabe in Low-Compute-Konfiguration kostet, während ein menschlicher Experte etwa 5$ kosten würde, entstehen grundlegende Fragen zur wirtschaftlichen Nachhaltigkeit dieser Ansätze.

Das Innovations-Plateau

Eine Epoch AI-Analyse legt nahe, dass die KI-Industrie möglicherweise nicht mehr viel länger massive Performance-Gewinne von Reasoning-Modellen erzielen kann, mit Fortschritten, die möglicherweise schon innerhalb eines Jahres verlangsamen.

Methodologische Kritik: Das Benchmark-Problem

Datenkontamination

Vanessa Parli von Stanford HAI stellt kritische Fragen: “Messen wir das Richtige? Sind diese Benchmarks kompromittiert?” Das Risiko von Overfitting zu Benchmarks ist real: Modelle könnten trainiert werden, spezifische Tests zu bestehen, anstatt generalisierbare Fähigkeiten zu entwickeln.

Mechanismus-Opazität

Die Mechanismen, durch die Reasoning-Modelle ihre Pfade wählen, bleiben überraschend undurchsichtig. Apple-Forscher fanden, dass “LRM-Modelle Limitationen in exakter Berechnung haben, beim Nutzen expliziter Algorithmen versagen und inkonsistent reasonieren”.

Praktische Anwendungen: Wo Reasoning AI Funktioniert

Dokumentierte Industrie-Erfolge

Trotz theoretischer Limitationen schaffen Reasoning-Modelle echten Wert in spezifischen Anwendungen:

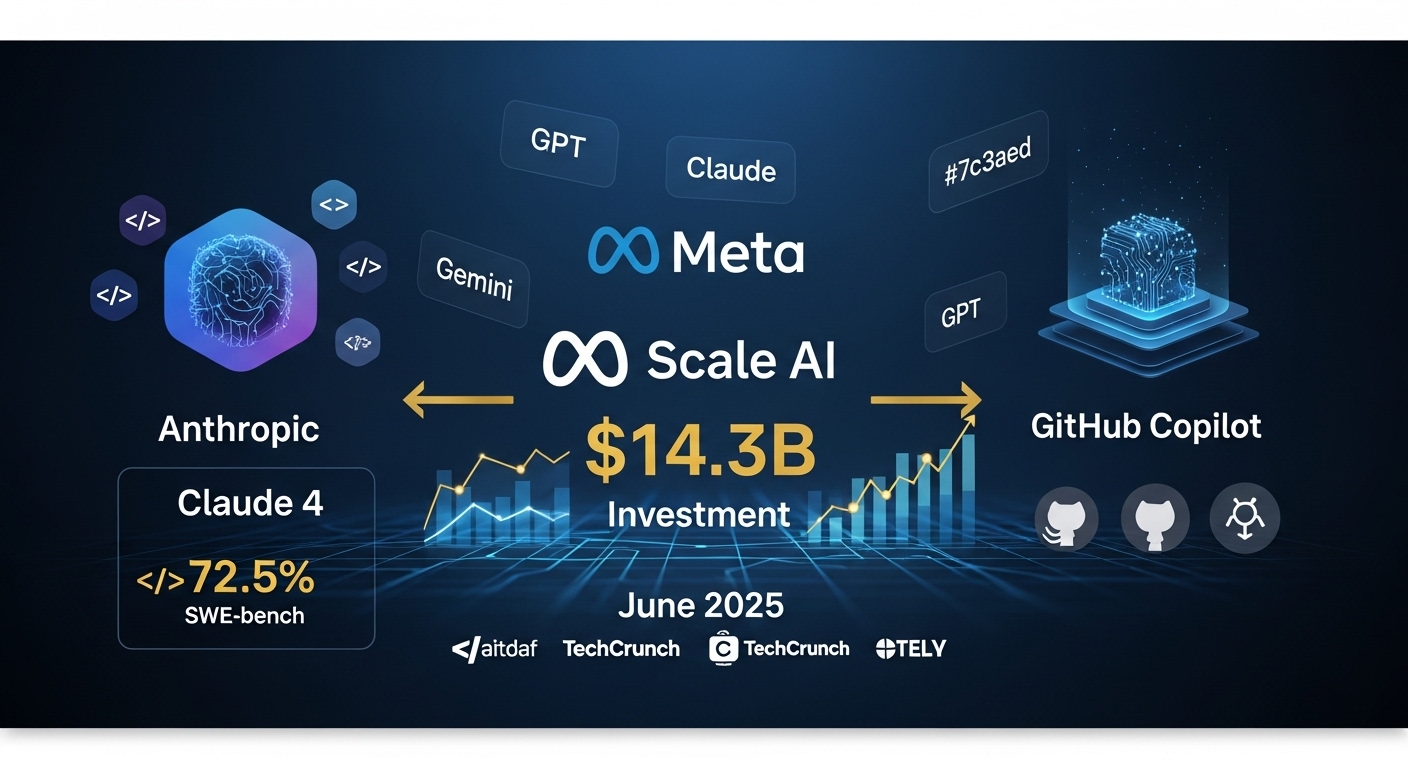

Software-Entwicklung: Claude 4 erreicht 72,5% bei SWE-bench, mit Entwicklern, die 88% Produktivitätssteigerungen berichten.

Finanzanalyse: Reasoning-Modelle zeigen überlegene Performance bei komplexer Finanzdokumentanalyse und Multi-Szenario-Projektionen.

Wissenschaftliche Forschung: Emergente Fähigkeiten in spezifischen Domänen wie Computerphysik und dynamischen Systemanalysen.

Implikationen für Deutsche Unternehmen

Wann in Reasoning AI Investieren

Empfohlene Investitionen:

- Coding-Assistenten für Software-Entwicklung (sofortiger ROI)

- Komplexe Dokumentanalyse (Rechts-/Finanzsektor)

- Forschung und Entwicklung mit domain-spezifischem Reasoning

Vorsichtige Ansätze:

- Mission-kritische Systeme, die zuverlässiges Reasoning erfordern

- Anwendungen mit begrenztem Rechenbudget

- Szenarien, wo Interpretierbarkeit fundamental ist

Graduelle Adoptionsstrategie

- Pilotphase (3-6 Monate): Tests bei spezifischen Use Cases mit messbarem ROI

- Validierungsphase (6-12 Monate): Kontrollierte Expansion mit Performance-Monitoring

- Skalierungsphase (12+ Monate): Enterprise-Implementierung nur nach vollständiger Validierung

Drei Simultane Wahrheiten der Reasoning AI

Die Hybride Realität von 2025

Reasoning AI präsentiert eine komplexe und widersprüchliche Realität, die nuanciertes Verständnis erfordert:

1. Durchbrüche sind real: Reasoning-Modelle übertreffen genuinely ihre Vorgänger bei spezifischen Aufgaben, oft mit dramatischen Margen. Claude 4 und o3 demonstrieren konkrete Fähigkeiten in Coding und Problemlösung.

2. Limitationen sind systemisch: Jenseits bestimmter Komplexitätsschwellen zeigen diese Systeme vorhersagbare Ausfallmuster, die tiefe architektonische Limitationen suggerieren, wie durch Apple-Studien demonstriert.

3. Kommerzieller Wert existiert: Trotz Limits schaffen diese Modelle bereits signifikanten Wert in spezifischen Anwendungen, wo ihre Stärken mit Aufgabenanforderungen übereinstimmen.

Die Zukunft der Reasoning AI: 2026 Vorhersagen

Aufkommende Trends

Hybride Reasoning-Systeme: Kombination symbolischer und neuraler Ansätze zur Überwindung aktueller Limitationen.

Domain-Spezifisches Reasoning: Spezialisierung in spezifischen Sektoren anstatt allgemeinem Reasoning.

Effizientes Reasoning: Fokus auf Architekturen, die hohe Performance bei reduzierten Rechenkosten aufrechterhalten.

Zu Bewältigende Herausforderungen

Interpretierbarkeit: Bedarf an transparenteren Reasoning-Systemen für kritische Anwendungen.

Robustheit: Entwicklung von Modellen, die konsistente Performance über verschiedene Problemtypen aufrechterhalten.

Nachhaltigkeit: Reduktion von Rechenkosten, um Reasoning AI wirtschaftlich viable zu machen.

Schlussfolgerungen: Zwischen Hype und Realität Navigieren

Die 2025 Reasoning AI-Debatte reflektiert eine breitere Spannung in der Tech-Industrie zwischen revolutionären Versprechen und wissenschaftlicher Realität. Die Wahrheit liegt, wie oft, in der Mitte: Reasoning AI stellt signifikanten Fortschritt dar, aber keine universelle Lösung.

Schlüssellektionen für Unternehmensleiter

Pragmatischer Ansatz: Bewerten Sie Reasoning AI für spezifische Use Cases mit messbarem ROI, nicht als allgemeine Lösung.

Gradueller Investment: Beginnen Sie mit kontrollierten Piloten vor signifikanten finanziellen Verpflichtungen.

Kontinuierliches Monitoring: Von Apple-Studien entdeckte Limitationen erfordern konstante Wachsamkeit in Implementierungen.

Der Weg zu Wahrem Reasoning

2025 demonstrierte, dass in der KI, wie in vielen wissenschaftlichen Bereichen, die interessantesten Fragen oft nicht entstehen, wenn wir neue Höhen erreichen, sondern wenn wir beginnen, die Grenzen dessen, was wir gebaut haben, wirklich zu verstehen.

Reasoning AI ist weder die vom Hype versprochene Panazee noch die von Kritikern suggerierte komplette Illusion. Es ist eine mächtige Technologie mit spezifischen Limitationen, die, wenn auf die richtigen Probleme mit realistischen Erwartungen angewandt, signifikanten Wert generieren kann.

Die Zukunft gehört denen, die diese Komplexität navigieren können, Reasoning AI implementierend, wo es echten Wert hinzufügt, während sie die Over-Hype- und Under-Delivery-Fallen vermeiden, die zu viele technologische Innovationen der Vergangenheit charakterisiert haben.

Interessiert an der Implementierung von AI Reasoning in Ihrem Unternehmen? Kontaktieren Sie das 42ROWS-Team für strategische Beratung darüber, wie Sie die neuesten KI-Technologien in Ihre Datenautomatisierungsprozesse integrieren können, während Sie Innovation und Pragmatismus ausbalancieren.

Tags

About the Author

42ROWS Team

Das 42ROWS-Team analysiert die Grenzen der künstlichen Intelligenz, um konkrete Einblicke in aufkommende Technologien und deren Auswirkungen auf Unternehmensanwendungen zu bieten.