Reasoning AI : L'Illusion de la Pensée - Analyse Complète entre Hype et Réalité 2025

OpenAI o3 atteint 88% sur ARC-AGI, mais Apple révèle que le reasoning AI est une illusion. Analyse approfondie des modèles de raisonnement : vraies percées ou pattern matching sophistiqué ? Toutes les données, coûts et limitations.

Table of Contents

2025 a été témoin du plus grand paradoxe de l’intelligence artificielle : tandis qu’OpenAI o3 atteignait des résultats records (88% sur ARC-AGI), Apple publiait une étude dévastatrice définissant les modèles de raisonnement comme “une illusion de la pensée”. Cette contradiction révèle une vérité inconfortable sur l’avenir de l’IA.

La Grande Contradiction du Reasoning AI

Imaginez lire deux titres le même jour : “OpenAI o3 révolutionne l’IA avec un raisonnement surhumain” et “Apple prouve que le reasoning AI est une illusion complète”. Bienvenue dans le paradoxe de 2025.

D’un côté, nous avons des percées technologiques sans précédent. De l’autre, des études scientifiques rigoureuses démontant les fondations théoriques de ces avancées. La réalité, comme souvent en technologie, est plus complexe que ne le suggèrent les titres sensationnalistes.

L’Explosion du Test-Time Compute Scaling

OpenAI o3 : La Révolution à 10 000$ par Tâche

Le test-time compute scaling a complètement changé les règles du jeu IA en 2025. OpenAI o3 utilise 170 fois plus de puissance computationnelle durant l’inférence comparé à la version efficiente, atteignant 88% sur ARC-AGI contre 76% de la version standard.

Le coût ? Plus de 10 000$ par tâche complexe. Pour mettre cela en perspective, François Chollet (créateur d’ARC-AGI) a calculé qu’on pourrait payer un humain environ 5$ pour la même tâche. Mais les résultats sont indéniables : o3 a obtenu 69,1% de précision sur SWE-Bench Verified, une amélioration substantielle par rapport aux 48,9% d’o1.

Démocratisation DeepSeek : Mêmes Résultats, Coûts Réduits

DeepSeek-R1 a déclenché la panique sur les marchés financiers quand il a démontré que des performances similaires à OpenAI o1 pouvaient être obtenues avec seulement 6 millions de dollars de développement. Le résultat ? Un effondrement de 17% des actions Nvidia en une seule session.

Ce modèle open-source a rendu évident que l’innovation en reasoning AI ne nécessite pas forcément des investissements milliardaires. DeepSeek-R1-Zero a développé naturellement des comportements de raisonnement avancés par apprentissage par renforcement pur, sans fine-tuning supervisé initial.

Apple Démolit le Mythe : “L’Illusion de la Pensée”

L’Étude Révolutionnaire du 7 Juin 2025

L’équipe Apple, dirigée par Parshin Shojaee et Samy Bengio, a publié “The Illusion of Thinking” utilisant une méthodologie complètement nouvelle. Au lieu de s’appuyer sur des benchmarks traditionnels (vulnérables à la contamination des données), ils ont créé des puzzles logiques contrôlables nécessitant un raisonnement pur.

Les résultats ont été dévastateurs pour l’industrie du reasoning AI.

Échecs Systémiques Découverts par Apple

Effondrement au-delà des seuils de complexité : Les modèles montrent un “effondrement complet de la précision” quand les problèmes dépassent certains seuils de difficulté. Paradoxalement, au lieu d’intensifier l’effort, les modèles réduisent le nombre de tokens utilisés et fournissent des réponses plus courtes.

Échec dans l’utilisation d’algorithmes explicites : Même quand fournis avec l’algorithme de solution pour la Tour de Hanoï, les performances ne s’amélioraient pas. Cela suggère des limitations fondamentales dans le maintien de chaînes de raisonnement cohérentes.

Le phénomène d’Overthinking : Pour des problèmes simples, les modèles non-reasoning surpassaient souvent les avancés, qui tendaient à “sur-réfléchir” et perdre la bonne réponse.

La Contre-Offensive : “L’Illusion de l’Illusion”

La Réponse de la Communauté Scientifique

Alex Lawsen d’Open Philanthropy a publié une réfutation détaillée intitulée “The Illusion of the Illusion of Thinking”, argumentant que beaucoup de résultats frappants d’Apple dérivent de défauts expérimentaux.

La critique principale ? Les limites de budget de tokens qu’Apple aurait ignorées dans l’interprétation des résultats. Quand Apple affirmait que les modèles “s’effondraient” sur les puzzles avec 8+ disques de la Tour de Hanoï, les modèles comme Claude atteignaient déjà leurs limites computationnelles.

Preuves Contradictoires de Stanford

Le Stanford AI Index 2025 présente une réalité complexe : tandis que les modèles de raisonnement se sont améliorés dramatiquement (o1 a obtenu 74,4% sur un examen des Olympiades Mathématiques Internationales, comparé aux 9,3% de GPT-4o), ils coûtent presque 6 fois plus et sont 30 fois plus lents.

Cependant, une tendance émergente montre la convergence des performances : l’écart entre le premier et le dixième modèle classé est tombé de 11,9% à 5,4% en un an, suggérant qu’on atteint un plateau dans les capacités fondamentales.

Méta-Analyse : Ce qui Fonctionne Vraiment

L’Étude Contre-Intuitive de Meta

Une recherche de Meta a révélé que les modèles IA atteignent une précision de 34,5% meilleure avec des chaînes de raisonnement plus courtes, défiant les suppositions de l’industrie et réduisant potentiellement les coûts computationnels de 40%.

Ce résultat contre-intuitif suggère que “plus de raisonnement” n’équivaut pas toujours à “meilleur raisonnement” - une découverte qui pourrait révolutionner l’approche du reasoning AI.

Meta-CoT de Stanford : L’Avenir du Reasoning

Des chercheurs de SynthLabs et Stanford ont proposé Meta Chain-of-Thought (Meta-CoT), un framework modélisant les processus de raisonnement latents nécessaires pour résoudre des problèmes complexes. Contrairement au CoT traditionnel, Meta-CoT incorpore une approche structurée inspirée de la théorie du double processus des sciences cognitives.

Comportements Émergents Non Programmés

L’Apprentissage Autonome de DeepSeek

DeepSeek-R1-Zero représente un cas d’étude fascinant : il a développé des comportements de raisonnement puissants par apprentissage par renforcement pur, sans fine-tuning supervisé initial. Cependant, il a aussi montré des défis comme une faible lisibilité et un mélange linguistique.

L’hypothèse de DeepSeek est audacieuse : “Pouvons-nous simplement récompenser le modèle pour la justesse et le laisser découvrir de manière autonome la meilleure façon de penser ?”

Capacités Émergentes dans les Domaines Scientifiques

Une comparaison dans les tâches de calcul scientifique a révélé que les trois modèles de reasoning (DeepSeek R1, ChatGPT o3-mini-high, et Claude 3.7 Sonnet) ont reconnu la rigidité du système ODE et choisi une méthode implicite, tandis que tous les modèles non-reasoning ont échoué.

Cela suggère des capacités émergentes authentiques dans des domaines spécifiques, même si les limitations générales demeurent.

Le Coût de la Complexité et la Scalabilité

Trade-offs Économiques Insoutenables

Le paradigme du test-time compute scaling présente des trade-offs drastiques. Avec o3 coûtant 17-20$ par tâche en configuration low-compute, tandis qu’un expert humain coûterait environ 5$, des questions fondamentales surgissent sur la soutenabilité économique de ces approches.

Le Plateau de l’Innovation

Une analyse d’Epoch AI suggère que l’industrie IA pourrait ne pas être capable d’obtenir des gains de performance massifs des modèles de reasoning beaucoup plus longtemps, avec des progrès pouvant ralentir dès l’année prochaine.

Critiques Méthodologiques : Le Problème des Benchmarks

Contamination des Données

Vanessa Parli de Stanford HAI pose des questions critiques : “Mesurons-nous la bonne chose ? Ces benchmarks sont-ils compromis ?” Le risque d’overfitting aux benchmarks est réel : les modèles pourraient être entraînés pour réussir des tests spécifiques plutôt que développer des capacités généralisables.

Opacité des Mécanismes

Les mécanismes par lesquels les modèles de reasoning choisissent leurs chemins restent étonnamment opaques. Les chercheurs Apple ont trouvé que “les modèles LRM ont des limitations dans le calcul exact, échouent à utiliser des algorithmes explicites et raisonnent de manière incohérente”.

Applications Pratiques : Où le Reasoning AI Fonctionne

Succès Documentés dans l’Industrie

Malgré les limitations théoriques, les modèles de reasoning créent de la valeur réelle dans des applications spécifiques :

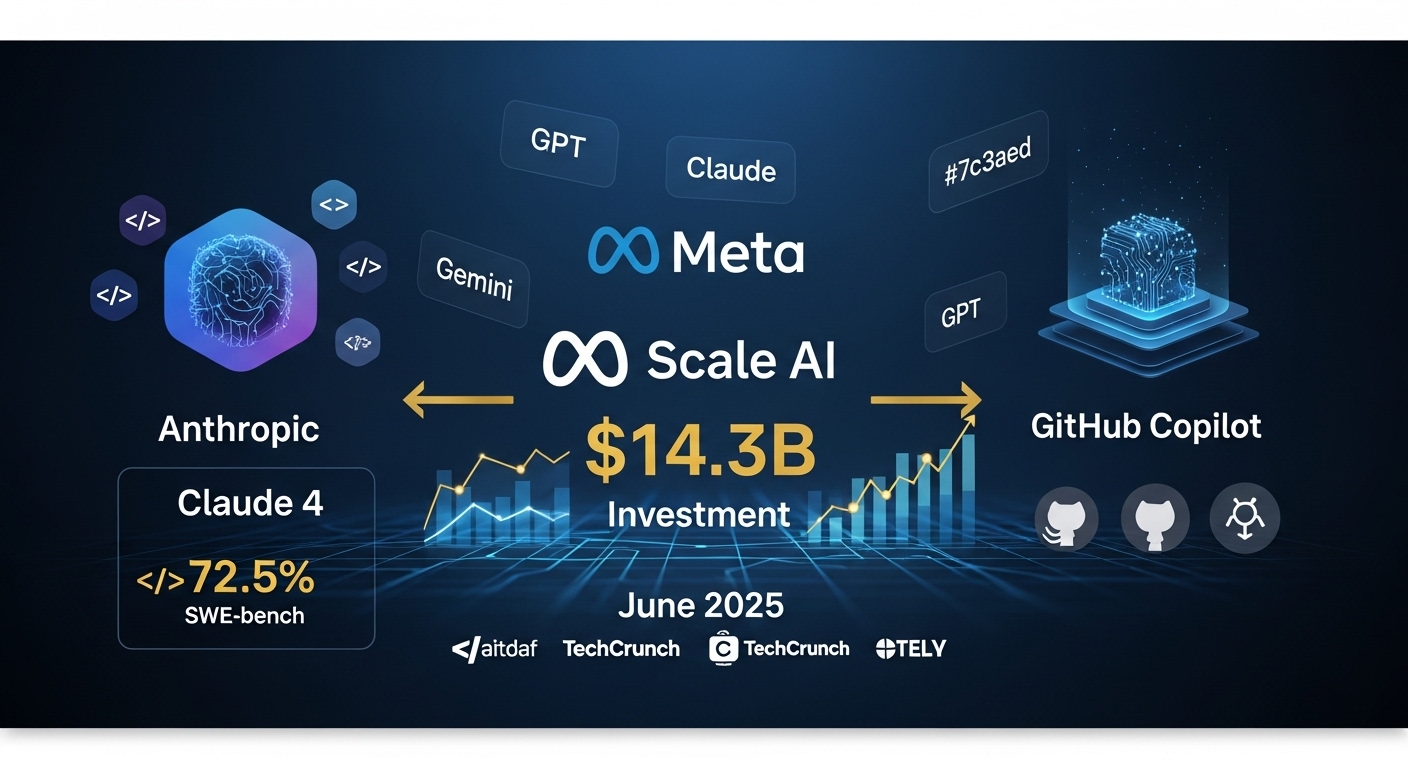

Développement Logiciel : Claude 4 atteint 72,5% sur SWE-bench, avec des développeurs rapportant des augmentations de productivité de 88%.

Analyse Financière : Les modèles de reasoning montrent des performances supérieures dans l’analyse de documents financiers complexes et les projections multi-scénarios.

Recherche Scientifique : Capacités émergentes dans des domaines spécifiques comme la physique computationnelle et l’analyse de systèmes dynamiques.

Implications pour les Entreprises Françaises

Quand Investir dans le Reasoning AI

Investissements Recommandés :

- Assistants de codage pour le développement logiciel (ROI immédiat)

- Analyse documentaire complexe (secteur légal/financier)

- Recherche et développement avec reasoning domain-spécifique

Approches Prudentes :

- Systèmes mission-critiques nécessitant un raisonnement fiable

- Applications avec budget computationnel limité

- Scénarios où l’interprétabilité est fondamentale

Stratégie d’Adoption Graduelle

- Phase Pilote (3-6 mois) : Tests sur des cas d’usage spécifiques avec ROI mesurable

- Phase de Validation (6-12 mois) : Expansion contrôlée avec monitoring des performances

- Phase d’Échelle (12+ mois) : Implémentation entreprise seulement après validation complète

Trois Vérités Simultanées du Reasoning AI

La Réalité Hybride de 2025

Le reasoning AI présente une réalité complexe et contradictoire nécessitant une compréhension nuancée :

1. Les percées sont réelles : Les modèles de reasoning surpassent genuinement leurs prédécesseurs sur des tâches spécifiques, souvent avec des marges dramatiques. Claude 4 et o3 démontrent des capacités concrètes en codage et résolution de problèmes.

2. Les limitations sont systémiques : Au-delà de certains seuils de complexité, ces systèmes montrent des patterns d’échec prévisibles suggérant des limitations architecturales profondes, comme démontré par les études Apple.

3. La valeur commerciale existe : Malgré les limites, ces modèles créent déjà une valeur significative dans des applications spécifiques où leurs forces s’alignent avec les exigences de la tâche.

L’Avenir du Reasoning AI : Prédictions pour 2026

Tendances Émergentes

Systèmes de Reasoning Hybrides : Combinaison d’approches symboliques et neurales pour surmonter les limitations actuelles.

Reasoning Domain-Spécifique : Spécialisation dans des secteurs spécifiques plutôt que reasoning général.

Reasoning Efficace : Focus sur des architectures maintenant des performances élevées tout en réduisant les coûts computationnels.

Défis à Relever

Interprétabilité : Besoin de systèmes de reasoning plus transparents pour les applications critiques.

Robustesse : Développement de modèles maintenant des performances consistantes à travers différents types de problèmes.

Soutenabilité : Réduction des coûts computationnels pour rendre le reasoning AI économiquement viable.

Conclusions : Naviguer Entre Hype et Réalité

Le débat sur le reasoning AI de 2025 reflète une tension plus large dans l’industrie tech entre promesses révolutionnaires et réalité scientifique. La vérité, comme souvent, se trouve au milieu : le reasoning AI représente un progrès significatif mais pas une solution universelle.

Leçons Clés pour les Leaders d’Entreprise

Approche Pragmatique : Évaluez le reasoning AI pour des cas d’usage spécifiques avec ROI mesurable, pas comme solution générale.

Investissement Graduel : Commencez avec des pilotes contrôlés avant des engagements financiers significatifs.

Surveillance Continue : Les limitations découvertes par les études Apple nécessitent une vigilance constante dans les implémentations.

Le Chemin vers le Vrai Reasoning

2025 a démontré qu’en IA, comme dans beaucoup de domaines scientifiques, les questions les plus intéressantes émergent souvent non pas quand on atteint de nouveaux sommets, mais quand on commence à vraiment comprendre les limites de ce qu’on a construit.

Le reasoning AI n’est ni la panacée promise par le hype ni l’illusion complète suggérée par les critiques. C’est une technologie puissante avec des limitations spécifiques qui, quand appliquée aux bons problèmes avec des attentes réalistes, peut générer une valeur significative.

L’avenir appartient à ceux qui sauront naviguer cette complexité, implémentant le reasoning AI là où il ajoute une valeur réelle tout en évitant les pièges de l’over-hype et de l’under-delivery qui ont caractérisé trop d’innovations technologiques du passé.

Intéressé par l’implémentation d’IA reasoning dans votre entreprise ? Contactez l’équipe 42ROWS pour un conseil stratégique sur comment intégrer les dernières technologies IA dans vos processus d’automatisation de données, équilibrant innovation et pragmatisme.

Tags

About the Author

Équipe 42ROWS

L'équipe 42ROWS analyse les frontières de l'intelligence artificielle pour fournir des insights concrets sur les technologies émergentes et leur impact sur les applications d'entreprise.