Reasoning AI: L'Illusione del Pensiero - Analisi Completa tra Hype e Realtà 2025

OpenAI o3 raggiunge l'88% su ARC-AGI, ma Apple svela che il reasoning AI è un'illusione. Analisi approfondita dei modelli di ragionamento: breakthrough reali o sofisticato pattern matching? Tutti i dati, costi e limitazioni.

Table of Contents

Il 2025 ha assistito al paradosso più grande dell’intelligenza artificiale: mentre OpenAI o3 raggiungeva risultati record (88% su ARC-AGI), Apple pubblicava uno studio devastante che definiva i modelli di reasoning “un’illusione del pensiero”. Questa contraddizione rivela una verità scomoda sul futuro dell’AI.

La Grande Contraddizione del Reasoning AI

Immaginate di leggere due notizie nello stesso giorno: “OpenAI o3 rivoluziona l’AI con reasoning superiore umano” e “Apple dimostra che il reasoning AI è un’illusione completa”. Benvenuti nel paradosso del 2025.

Da un lato, abbiamo breakthrough tecnologici senza precedenti. Dall’altro, studi scientifici rigorosi che smontano le basi teoriche di questi progressi. La realtà, come spesso accade nella tecnologia, è più complessa di quanto i titoli sensazionalistici suggeriscano.

L’Esplosione del Test-Time Compute Scaling

OpenAI o3: La Rivoluzione da $10.000 per Task

Il test-time compute scaling ha cambiato completamente le regole del gioco AI nel 2025. OpenAI o3 utilizza 170 volte più potenza computazionale durante l’inferenza rispetto alla versione efficiente, raggiungendo l’88% su ARC-AGI contro il 76% della versione standard.

Il costo? Oltre $10.000 per task complesso. Per mettere questo in prospettiva, François Chollet (creatore di ARC-AGI) ha calcolato che potreste pagare un umano circa $5 per lo stesso compito. Ma i risultati sono innegabili: o3 ha ottenuto il 69,1% di accuratezza su SWE-Bench Verified, un miglioramento sostanziale rispetto al 48,9% di o1.

La Democratizzazione DeepSeek: Stessi Risultati, Costi Ridotti

DeepSeek-R1 ha scatenato il panico sui mercati finanziari quando ha dimostrato che prestazioni simili a OpenAI o1 potevano essere ottenute con soli 6 milioni di dollari di sviluppo. Il risultato? Un crollo del 17% delle azioni Nvidia in una singola sessione.

Questo modello open-source ha reso evidente che l’innovazione nel reasoning AI non richiede necessariamente investimenti miliardari. DeepSeek-R1-Zero ha sviluppato naturalmente comportamenti di reasoning avanzati attraverso il reinforcement learning puro, senza supervised fine-tuning iniziale.

Apple Demolisce il Mito: “L’Illusione del Pensiero”

Lo Studio Rivoluzionario del 7 Giugno 2025

Il team di Apple, guidato da Parshin Shojaee e Samy Bengio, ha pubblicato “The Illusion of Thinking” utilizzando una metodologia completamente nuova. Invece di affidarsi a benchmark tradizionali (vulnerabili alla contaminazione dei dati), hanno creato puzzle logici controllabili che richiedevano ragionamento puro.

I risultati sono stati devastanti per l’industria del reasoning AI.

I Fallimenti Sistemici Scoperti da Apple

Crollo oltre le soglie di complessità: I modelli mostrano un “crollo completo dell’accuratezza” quando i problemi superano certe soglie di difficoltà. Paradossalmente, invece di intensificare lo sforzo, i modelli riducono il numero di token utilizzati e forniscono risposte più brevi.

Fallimento nell’utilizzo di algoritmi espliciti: Anche quando forniti con l’algoritmo di soluzione per la Torre di Hanoi, le performance non miglioravano. Questo suggerisce limitazioni fondamentali nel mantenere catene di ragionamento coerenti.

Il fenomeno dell’Overthinking: Per problemi semplici, i modelli non-reasoning spesso superavano quelli avanzati, che tendevano a “sovrapensare” e perdere la risposta corretta.

La Controffensiva: “L’Illusione dell’Illusione”

La Risposta della Comunità Scientifica

Alex Lawsen di Open Philanthropy ha pubblicato una confutazione dettagliata intitolata “The Illusion of the Illusion of Thinking”, argomentando che molti risultati clamorosi di Apple derivano da difetti sperimentali.

La critica principale? I limiti di token budget che Apple avrebbe ignorato nell’interpretazione dei risultati. Quando Apple affermava che i modelli “crollavano” sui puzzle con 8+ dischi della Torre di Hanoi, i modelli come Claude stavano già raggiungendo i loro limiti computazionali.

L’Evidenza Contraddittoria di Stanford

Lo Stanford AI Index 2025 presenta una realtà complessa: mentre i modelli di reasoning hanno migliorato drasticamente (o1 ha ottenuto il 74,4% su un esame delle Olimpiadi Matematiche Internazionali, rispetto al 9,3% di GPT-4o), costano quasi 6 volte di più e sono 30 volte più lenti.

Tuttavia, un trend emergente mostra la convergenza delle performance: il divario tra il primo e il decimo modello classificato è sceso dall’11,9% al 5,4% in un anno, suggerendo che stiamo raggiungendo un plateau nelle capacità fondamentali.

Meta-Analisi: Cosa Funziona Davvero

Lo Studio Controintuitivo di Meta

Una ricerca di Meta ha rivelato che i modelli AI raggiungono un’accuratezza migliore del 34,5% con catene di ragionamento più brevi, sfidando le assunzioni dell’industria e potenzialmente riducendo i costi computazionali del 40%.

Questo risultato controintuitivo suggerisce che “più ragionamento” non sempre equivale a “migliore ragionamento” - una scoperta che potrebbe rivoluzionare l’approccio al reasoning AI.

Meta-CoT di Stanford: Il Futuro del Reasoning

Ricercatori di SynthLabs e Stanford hanno proposto Meta Chain-of-Thought (Meta-CoT), un framework che modella i processi di ragionamento latenti necessari per risolvere problemi complessi. A differenza del CoT tradizionale, Meta-CoT incorpora un approccio strutturato ispirato alla teoria del doppio processo delle scienze cognitive.

Comportamenti Emergenti Non Programmati

L’Apprendimento Autonomo di DeepSeek

DeepSeek-R1-Zero rappresenta un caso studio affascinante: ha sviluppato comportamenti di reasoning potenti attraverso il reinforcement learning puro, senza supervised fine-tuning iniziale. Tuttavia, ha anche mostrato sfide come scarsa leggibilità e mixing linguistico.

L’ipotesi di DeepSeek è audace: “Possiamo semplicemente premiare il modello per la correttezza e lasciare che scopra autonomamente il modo migliore di pensare?”

Capacità Emergenti nei Domini Scientifici

Una comparazione nei task di computing scientifico ha rivelato che tutti e tre i modelli di reasoning (DeepSeek R1, ChatGPT o3-mini-high, e Claude 3.7 Sonnet) hanno riconosciuto la rigidità del sistema ODE e scelto un metodo implicito, mentre tutti i modelli non-reasoning hanno fallito.

Questo suggerisce capacità emergenti genuine in domini specifici, anche se le limitazioni generali rimangono.

Il Costo della Complessità e la Scalabilità

Trade-off Economici Insostenibili

Il paradigma del test-time compute scaling presenta trade-off drastici. Con o3 che costa $17-20 per task nella configurazione low-compute, mentre un esperto umano costerebbe circa $5, sorgono domande fondamentali sulla sostenibilità economica di questi approcci.

Il Plateau dell’Innovazione

Un’analisi di Epoch AI suggerisce che l’industria AI potrebbe non essere in grado di ottenere guadagni di performance massivi dai modelli di reasoning per molto più tempo, con progressi che potrebbero rallentare già entro un anno.

Critiche Metodologiche: Il Problema dei Benchmark

La Contaminazione dei Dati

Vanessa Parli di Stanford HAI pone domande critiche: “Stiamo misurando la cosa giusta? Questi benchmark sono compromessi?” Il rischio di overfitting ai benchmark è reale: i modelli potrebbero essere addestrati per superare test specifici piuttosto che sviluppare capacità generalizzabili.

L’Opacità dei Meccanismi

I meccanismi attraverso cui i modelli di reasoning scelgono i loro percorsi rimangono sorprendentemente opachi. I ricercatori Apple hanno trovato che “i modelli LRM hanno limitazioni nel calcolo esatto, falliscono nell’utilizzare algoritmi espliciti e ragionano in modo inconsistente”.

Applicazioni Pratiche: Dove il Reasoning AI Funziona

Successi Documentati nell’Industria

Nonostante le limitazioni teoriche, i modelli di reasoning stanno creando valore reale in applicazioni specifiche:

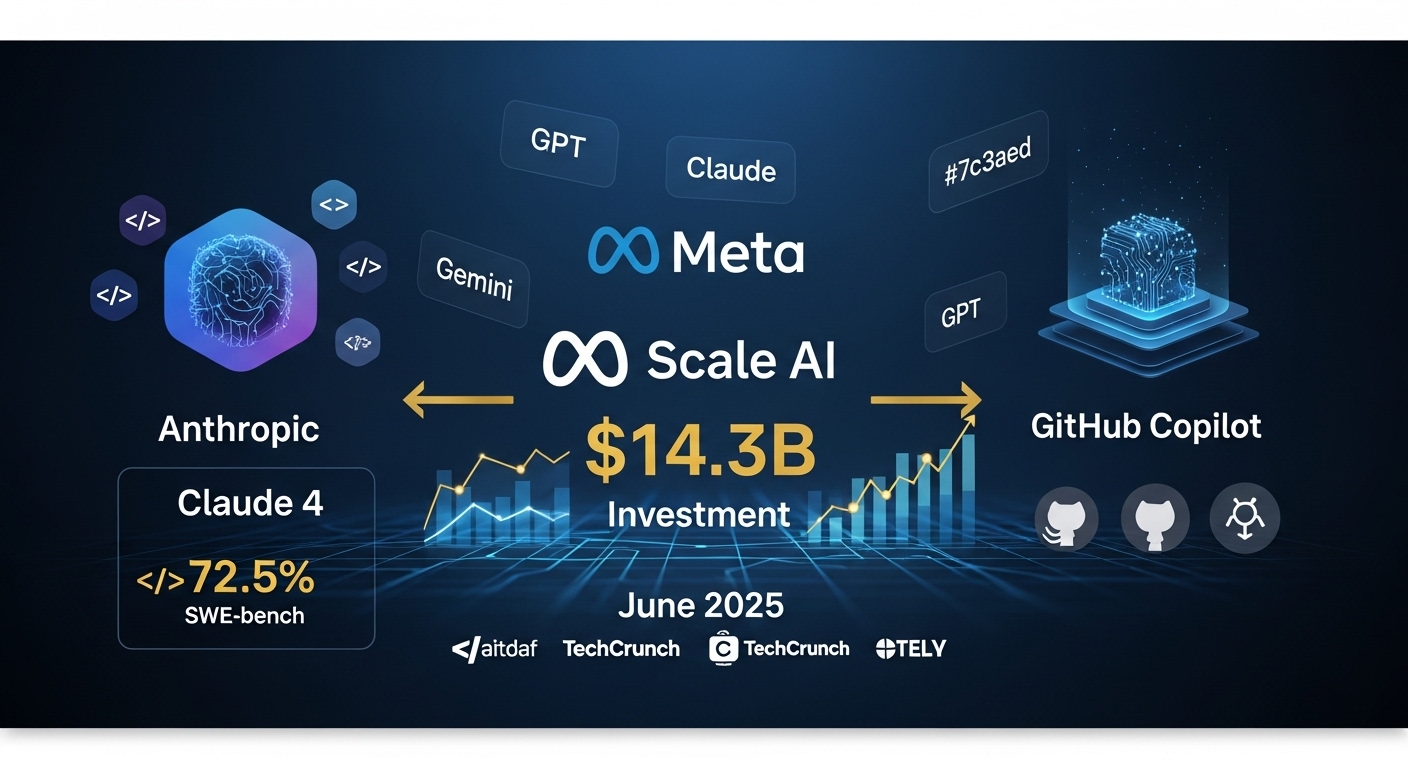

Sviluppo Software: Claude 4 raggiunge il 72,5% su SWE-bench, con sviluppatori che riportano aumenti di produttività dell’88%.

Analisi Finanziaria: Modelli di reasoning mostrano performance superiori nell’analisi di documenti finanziari complessi e proiezioni multi-scenario.

Ricerca Scientifica: Capacità emergenti in domini specifici come la fisica computazionale e l’analisi di sistemi dinamici.

Implicazioni per le Aziende Italiane

Quando Investire nel Reasoning AI

Investimenti Consigliati:

- Coding assistants per sviluppo software (ROI immediato)

- Analisi documentale complessa (settore legale/finanziario)

- Ricerca e sviluppo con reasoning domain-specific

Approcci Cauti:

- Sistemi mission-critical che richiedono ragionamento affidabile

- Applicazioni con budget computazionale limitato

- Scenari dove l’interpretabilità è fondamentale

Strategia di Adozione Graduale

- Fase Pilota (3-6 mesi): Test su use case specifici con ROI misurabile

- Fase di Validazione (6-12 mesi): Espansione controllata con monitoraggio performance

- Fase di Scale (12+ mesi): Implementazione enterprise solo dopo validazione completa

Tre Verità Simultanee del Reasoning AI

La Realtà Ibrida del 2025

Il reasoning AI presenta una realtà complessa e contraddittoria che richiede una comprensione sfumata:

1. I breakthrough sono reali: I modelli di reasoning superano genuinamente i loro predecessori su compiti specifici, spesso con margini drammatici. Claude 4 e o3 dimostrano capacità concrete in coding e problem-solving.

2. Le limitazioni sono sistemiche: Oltre certe soglie di complessità, questi sistemi mostrano pattern di fallimento prevedibili che suggeriscono limitazioni architetturali profonde, come dimostrato dagli studi Apple.

3. Il valore commerciale esiste: Nonostante i limiti, questi modelli stanno già creando valore significativo in applicazioni specifiche dove i loro punti di forza si allineano con i requisiti del task.

Il Futuro del Reasoning AI: Previsioni per il 2026

Trend Emergenti

Hybrid Reasoning Systems: Combinazione di approcci simbolici e neurali per superare le limitazioni attuali.

Domain-Specific Reasoning: Specializzazione in settori specifici piuttosto che reasoning generale.

Efficient Reasoning: Focus su architetture che mantengono performance elevate riducendo i costi computazionali.

Sfide da Affrontare

Interpretabilità: Necessità di sistemi reasoning più trasparenti per applicazioni critiche.

Robustezza: Sviluppo di modelli che mantengono performance consistenti attraverso diversi tipi di problemi.

Sostenibilità: Riduzione dei costi computazionali per rendere il reasoning AI economicamente viabile.

Conclusioni: Navigare Tra Hype e Realtà

Il dibattito sul reasoning AI del 2025 riflette una tensione più ampia nell’industria tech tra promesse rivoluzionarie e realtà scientifica. La verità, come spesso accade, si trova nel mezzo: il reasoning AI rappresenta un progresso significativo ma non una soluzione universale.

Lezioni Chiave per Leader Aziendali

Approccio Pragmatico: Valutate il reasoning AI per use case specifici con ROI misurabile, non come soluzione generale.

Investimento Graduale: Iniziate con piloti controllati prima di impegni finanziari significativi.

Monitoraggio Continuo: Le limitazioni scoperte dagli studi Apple richiedono vigilanza costante nelle implementazioni.

La Strada Verso il Vero Reasoning

Il 2025 ha dimostrato che nell’AI, come in molti campi scientifici, le domande più interessanti emergono spesso non quando raggiungiamo nuove vette, ma quando iniziamo a comprendere veramente i limiti di ciò che abbiamo costruito.

Il reasoning AI non è né la panacea promessa dall’hype né l’illusione completa suggerita dai critici. È una tecnologia potente con limitazioni specifiche che, quando applicata ai problemi giusti con aspettative realistiche, può generare valore significativo.

Il futuro appartiene a chi saprà navigare questa complessità, implementando il reasoning AI dove aggiunge valore reale mentre evita le trappole dell’over-hype e dell’under-delivery che hanno caratterizzato troppe innovazioni tecnologiche del passato.

Interessato a implementare AI reasoning nella tua azienda? Contatta il team 42ROWS per una consulenza strategica su come integrare le ultime tecnologie AI nei tuoi processi di automazione dati, bilanciando innovazione e pragmatismo.

Tags

About the Author

Team 42ROWS

Il team 42ROWS analizza le frontiere dell'intelligenza artificiale per fornire insights concreti su tecnologie emergenti e il loro impatto sulle applicazioni enterprise.