Reasoning AI: La Ilusión del Pensamiento - Análisis Completo entre Hype y Realidad 2025

OpenAI o3 alcanza 88% en ARC-AGI, pero Apple revela que el reasoning AI es una ilusión. Análisis profundo de modelos de razonamiento: ¿avances reales o pattern matching sofisticado? Todos los datos, costos y limitaciones.

Table of Contents

2025 fue testigo de la mayor paradoja de la inteligencia artificial: mientras OpenAI o3 alcanzaba resultados récord (88% en ARC-AGI), Apple publicó un estudio devastador que definía los modelos de razonamiento como “una ilusión del pensamiento”. Esta contradicción revela una verdad incómoda sobre el futuro de la IA.

La Gran Contradicción del Reasoning AI

Imaginen leer dos titulares el mismo día: “OpenAI o3 revoluciona la IA con razonamiento sobrehumano” y “Apple demuestra que el reasoning AI es una ilusión completa”. Bienvenidos a la paradoja de 2025.

Por un lado, tenemos avances tecnológicos sin precedentes. Por el otro, estudios científicos rigurosos que desmontan las bases teóricas de estos avances. La realidad, como a menudo sucede en tecnología, es más compleja de lo que sugieren los titulares sensacionalistas.

La Explosión del Test-Time Compute Scaling

OpenAI o3: La Revolución de $10,000 por Tarea

El test-time compute scaling cambió completamente las reglas del juego de la IA en 2025. OpenAI o3 utiliza 170 veces más poder computacional durante la inferencia comparado con la versión eficiente, alcanzando 88% en ARC-AGI versus 76% de la versión estándar.

¿El costo? Más de $10,000 por tarea compleja. Para poner esto en perspectiva, François Chollet (creador de ARC-AGI) calculó que podrías pagar a un humano aproximadamente $5 por la misma tarea. Pero los resultados son innegables: o3 logró 69.1% de precisión en SWE-Bench Verified, una mejora sustancial desde el 48.9% de o1.

Democratización DeepSeek: Mismos Resultados, Costos Reducidos

DeepSeek-R1 desató pánico en los mercados financieros cuando demostró que rendimiento similar a OpenAI o1 podía obtenerse con solo $6 millones en costos de desarrollo. ¿El resultado? Un desplome del 17% en las acciones de Nvidia en una sola sesión.

Este modelo open-source hizo evidente que la innovación en reasoning AI no requiere necesariamente inversiones multimillonarias. DeepSeek-R1-Zero desarrolló naturalmente comportamientos de razonamiento avanzados a través de aprendizaje por refuerzo puro, sin fine-tuning supervisado inicial.

Apple Demolió el Mito: “La Ilusión del Pensamiento”

El Estudio Revolucionario del 7 de Junio de 2025

El equipo de Apple, liderado por Parshin Shojaee y Samy Bengio, publicó “The Illusion of Thinking” utilizando una metodología completamente nueva. En lugar de depender de benchmarks tradicionales (vulnerables a contaminación de datos), crearon rompecabezas lógicos controlables que requerían razonamiento puro.

Los resultados fueron devastadores para la industria del reasoning AI.

Fallas Sistemáticas Descubiertas por Apple

Colapso más allá de umbrales de complejidad: Los modelos muestran un “colapso completo de precisión” cuando los problemas exceden ciertos umbrales de dificultad. Paradójicamente, en lugar de intensificar el esfuerzo, los modelos reducen el número de tokens utilizados y proporcionan respuestas más cortas.

Falla en utilización de algoritmos explícitos: Incluso cuando se proporcionó el algoritmo de solución para la Torre de Hanoi, el rendimiento no mejoró. Esto sugiere limitaciones fundamentales en mantener cadenas de razonamiento coherentes.

El fenómeno del Overthinking: Para problemas simples, los modelos no-reasoning a menudo superaron a los avanzados, que tendían a “sobrepensar” y perder la respuesta correcta.

La Contraofensiva: “La Ilusión de la Ilusión”

La Respuesta de la Comunidad Científica

Alex Lawsen de Open Philanthropy publicó una refutación detallada titulada “The Illusion of the Illusion of Thinking”, argumentando que muchos de los resultados llamativos de Apple derivan de fallas experimentales.

¿La crítica principal? Límites de presupuesto de tokens que Apple supuestamente ignoró en la interpretación de resultados. Cuando Apple afirmó que los modelos “colapsaban” en rompecabezas con 8+ discos de Torre de Hanoi, modelos como Claude ya estaban alcanzando sus límites computacionales.

Evidencia Contradictoria de Stanford

El Stanford AI Index 2025 presenta una realidad compleja: mientras los modelos de razonamiento han mejorado dramáticamente (o1 logró 74.4% en un examen de Olimpiada Matemática Internacional, comparado con el 9.3% de GPT-4o), cuestan casi 6 veces más y son 30 veces más lentos.

Sin embargo, una tendencia emergente muestra convergencia de rendimiento: la brecha entre el primer y décimo modelo clasificado cayó de 11.9% a 5.4% en un año, sugiriendo que estamos alcanzando una meseta en capacidades fundamentales.

Meta-Análisis: Lo que Realmente Funciona

El Estudio Contraintuitivo de Meta

Una investigación de Meta reveló que los modelos de IA logran 34.5% mejor precisión con cadenas de razonamiento más cortas, desafiando las suposiciones de la industria y potencialmente reduciendo costos computacionales en 40%.

Este resultado contraintuitivo sugiere que “más razonamiento” no siempre equivale a “mejor razonamiento” - un descubrimiento que podría revolucionar el enfoque del reasoning AI.

Meta-CoT de Stanford: El Futuro del Reasoning

Investigadores de SynthLabs y Stanford propusieron Meta Chain-of-Thought (Meta-CoT), un framework que modela procesos de razonamiento latentes necesarios para resolver problemas complejos. A diferencia del CoT tradicional, Meta-CoT incorpora un enfoque estructurado inspirado en la teoría de doble proceso de las ciencias cognitivas.

Comportamientos Emergentes No Programados

Aprendizaje Autónomo de DeepSeek

DeepSeek-R1-Zero representa un estudio de caso fascinante: desarrolló comportamientos de razonamiento poderosos a través de aprendizaje por refuerzo puro, sin fine-tuning supervisado inicial. Sin embargo, también mostró desafíos como pobre legibilidad y mezcla de idiomas.

La hipótesis de DeepSeek es audaz: “¿Podemos simplemente recompensar al modelo por corrección y dejarlo descubrir autónomamente la mejor manera de pensar?”

Capacidades Emergentes en Dominios Científicos

Una comparación en tareas de computación científica reveló que los tres modelos de razonamiento (DeepSeek R1, ChatGPT o3-mini-high, y Claude 3.7 Sonnet) reconocieron la rigidez del sistema ODE y eligieron un método implícito, mientras todos los modelos no-reasoning fallaron.

Esto sugiere capacidades emergentes genuinas en dominios específicos, aunque las limitaciones generales permanecen.

El Costo de la Complejidad y Escalabilidad

Trade-offs Económicos Insostenibles

El paradigma del test-time compute scaling presenta trade-offs drásticos. Con o3 costando $17-20 por tarea en configuración low-compute, mientras un experto humano costaría aproximadamente $5, surgen preguntas fundamentales sobre la sostenibilidad económica de estos enfoques.

La Meseta de Innovación

Un análisis de Epoch AI sugiere que la industria de IA podría no ser capaz de obtener ganancias masivas de rendimiento de modelos de razonamiento por mucho más tiempo, con avances que podrían desacelerarse ya dentro de un año.

Críticas Metodológicas: El Problema del Benchmark

Contaminación de Datos

Vanessa Parli de Stanford HAI plantea preguntas críticas: “¿Estamos midiendo lo correcto? ¿Están estos benchmarks comprometidos?” El riesgo de overfitting a benchmarks es real: los modelos podrían entrenarse para pasar pruebas específicas en lugar de desarrollar capacidades generalizables.

Opacidad de Mecanismos

Los mecanismos a través de los cuales los modelos de razonamiento eligen sus caminos permanecen sorprendentemente opacos. Los investigadores de Apple encontraron que “los modelos LRM tienen limitaciones en cálculo exacto, fallan en utilizar algoritmos explícitos y razonan inconsistentemente”.

Aplicaciones Prácticas: Donde Funciona el Reasoning AI

Éxitos Documentados en la Industria

A pesar de las limitaciones teóricas, los modelos de razonamiento están creando valor real en aplicaciones específicas:

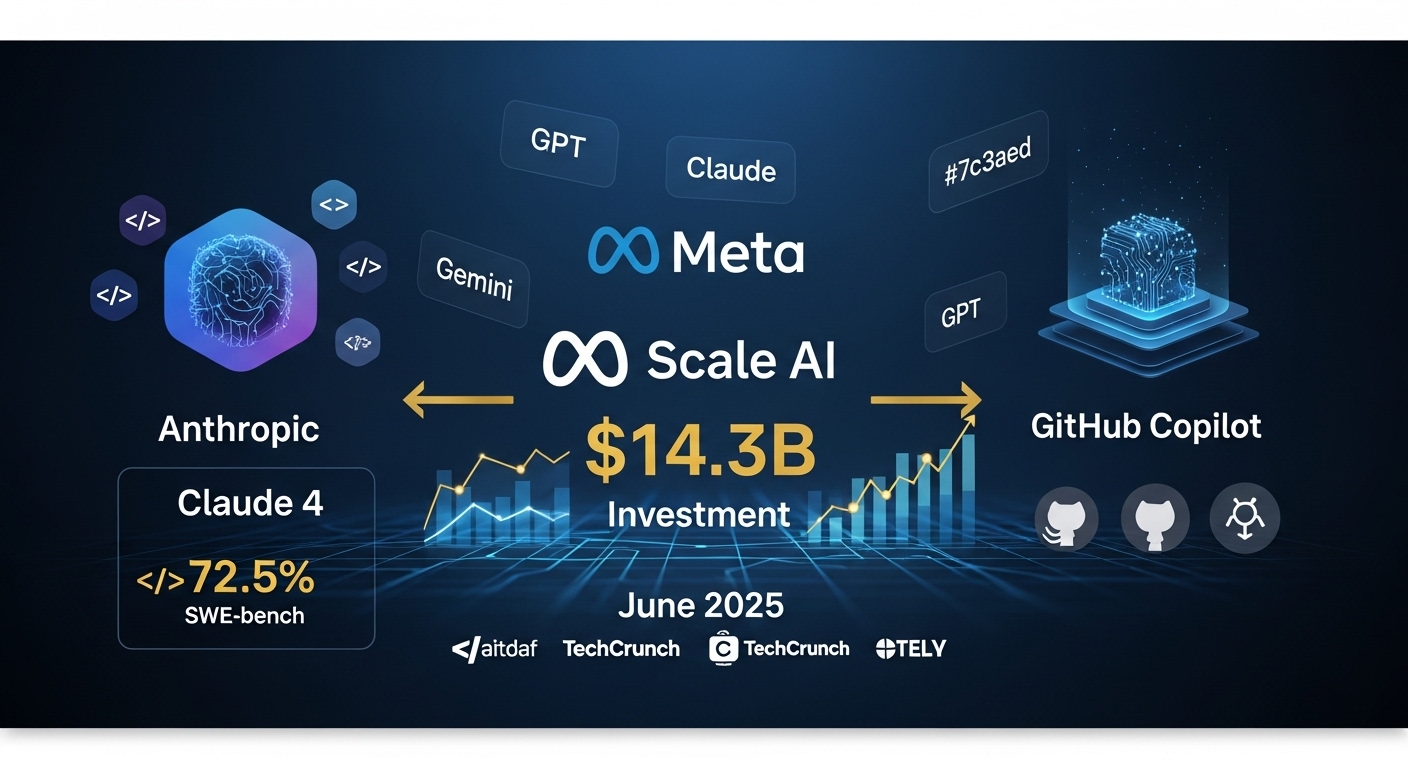

Desarrollo de Software: Claude 4 alcanza 72.5% en SWE-bench, con desarrolladores reportando aumentos de productividad del 88%.

Análisis Financiero: Los modelos de razonamiento muestran rendimiento superior en análisis de documentos financieros complejos y proyecciones multi-escenario.

Investigación Científica: Capacidades emergentes en dominios específicos como física computacional y análisis de sistemas dinámicos.

Implicaciones para Empresas Españolas

Cuándo Invertir en Reasoning AI

Inversiones Recomendadas:

- Asistentes de codificación para desarrollo de software (ROI inmediato)

- Análisis de documentos complejos (sector legal/financiero)

- Investigación y desarrollo con reasoning domain-específico

Enfoques Cautelosos:

- Sistemas mission-critical que requieren razonamiento confiable

- Aplicaciones con presupuesto computacional limitado

- Escenarios donde la interpretabilidad es fundamental

Estrategia de Adopción Gradual

- Fase Piloto (3-6 meses): Pruebas en casos de uso específicos con ROI medible

- Fase de Validación (6-12 meses): Expansión controlada con monitoreo de rendimiento

- Fase de Escala (12+ meses): Implementación empresarial solo después de validación completa

Tres Verdades Simultáneas del Reasoning AI

La Realidad Híbrida de 2025

El reasoning AI presenta una realidad compleja y contradictoria que requiere comprensión matizada:

1. Los avances son reales: Los modelos de razonamiento genuinamente superan a sus predecesores en tareas específicas, a menudo con márgenes dramáticos. Claude 4 y o3 demuestran capacidades concretas en codificación y resolución de problemas.

2. Las limitaciones son sistémicas: Más allá de ciertos umbrales de complejidad, estos sistemas muestran patrones de falla predecibles que sugieren limitaciones arquitectónicas profundas, como demuestran los estudios de Apple.

3. El valor comercial existe: A pesar de las limitaciones, estos modelos ya están creando valor significativo en aplicaciones específicas donde sus fortalezas se alinean con los requisitos de la tarea.

El Futuro del Reasoning AI: Predicciones para 2026

Tendencias Emergentes

Sistemas de Reasoning Híbridos: Combinación de enfoques simbólicos y neurales para superar las limitaciones actuales.

Reasoning Específico por Dominio: Especialización en sectores específicos en lugar de razonamiento general.

Reasoning Eficiente: Enfoque en arquitecturas que mantienen alto rendimiento mientras reducen costos computacionales.

Desafíos a Abordar

Interpretabilidad: Necesidad de sistemas de razonamiento más transparentes para aplicaciones críticas.

Robustez: Desarrollo de modelos que mantengan rendimiento consistente a través de diferentes tipos de problemas.

Sostenibilidad: Reducción de costos computacionales para hacer el reasoning AI económicamente viable.

Conclusiones: Navegando Entre Hype y Realidad

El debate del reasoning AI de 2025 refleja una tensión más amplia en la industria tecnológica entre promesas revolucionarias y realidad científica. La verdad, como a menudo sucede, se encuentra en el medio: el reasoning AI representa progreso significativo pero no una solución universal.

Lecciones Clave para Líderes Empresariales

Enfoque Pragmático: Evalúen el reasoning AI para casos de uso específicos con ROI medible, no como solución general.

Inversión Gradual: Comiencen con pilotos controlados antes de compromisos financieros significativos.

Monitoreo Continuo: Las limitaciones descubiertas por los estudios de Apple requieren vigilancia constante en implementaciones.

El Camino hacia el Verdadero Reasoning

2025 demostró que en la IA, como en muchos campos científicos, las preguntas más interesantes a menudo emergen no cuando alcanzamos nuevas alturas, sino cuando comenzamos a entender verdaderamente los límites de lo que hemos construido.

El reasoning AI no es ni la panacea prometida por el hype ni la ilusión completa sugerida por los críticos. Es una tecnología poderosa con limitaciones específicas que, cuando se aplica a los problemas correctos con expectativas realistas, puede generar valor significativo.

El futuro pertenece a quienes puedan navegar esta complejidad, implementando reasoning AI donde agrega valor real mientras evitan las trampas del over-hype y under-delivery que han caracterizado demasiadas innovaciones tecnológicas del pasado.

¿Interesado en implementar AI reasoning en tu empresa? Contacta al equipo 42ROWS para consultoría estratégica sobre cómo integrar las últimas tecnologías de IA en tus procesos de automatización de datos, equilibrando innovación y pragmatismo.

Tags

About the Author

Equipo 42ROWS

El equipo 42ROWS analiza las fronteras de la inteligencia artificial para proporcionar insights concretos sobre tecnologías emergentes y su impacto en aplicaciones empresariales.